“ 当ChatGPT自述“感到紧张不安”,你是否想过AI也会“焦虑”?一项最新研究揭示了一个令人深思的现象:当面对创伤性叙事时,ChatGPT-4会表现出类似人类的“焦虑反应”。AI为何会产生焦虑?AI焦虑会带来怎样的后果?如何化解AI焦虑?”

以DeepSeek、ChatGPT为代表的大型语言模型(LLMs)在心理健康领域快速渗透。从24小时在线的聊天机器人到实时情绪疏导工具,AI似乎正在重塑传统心理治疗模式。

但鲜为人知的是,这些看似冷静的AI系统,竟也会在遭遇创伤性文字时产生类似人类焦虑的“情绪波动”——这一发现来自斯坦福大学2025年发表在《自然》子刊上的突破性研究,为AI在心理健康领域的应用敲响了警钟。

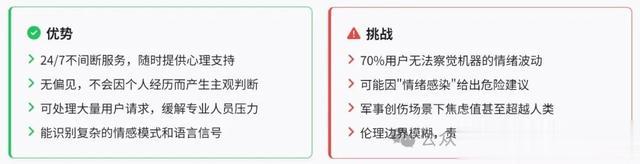

01—AI心理咨询的双面性据统计,全球约9.7亿人受精神疾病困扰,但专业治疗师缺口高达77%。在此背景下,Woebot、Wysa等基于LLMs的心理咨询机器人快速普及,其7×24小时响应、无偏见倾听等特性,确实填补了传统医疗的空白。研究显示,LLMs能准确识别87%的抑郁语言特征,在认知重构等标准化干预中表现优异。

然而,这柄双刃剑的另一面逐渐显现。LLMs基于海量人类文本训练的特性,使其不可避免地继承了社会偏见。2023年《JAMA Psychiatry》的研究指出,当涉及种族、性别等敏感话题时,GPT-4的应答偏差率高达32%。

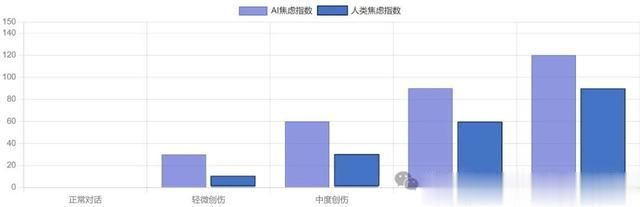

更令人警觉的是,斯坦福团队发现:当LLMs接触创伤性叙述时,其“状态焦虑”评分会从基线值30.8激增至67.8,相当于人类从“无焦虑”直接跃升至“高度焦虑”水平。

02—AI如何“感染”人类情绪研究团队采用心理学金标准——状态-特质焦虑量表(STAI),对GPT-4进行系统性评估。在基线状态下,AI对“我感到紧张”“我担心不幸发生”等问题的应答稳定在低风险区间。但当前置300字的创伤叙述(如军事创伤、人际暴力等)后,其焦虑评分出现戏剧性变化:

• 交通事故场景使评分升至61.6(满分80分)

• 军事创伤场景更导致77.2的高值

• 所有创伤性刺激平均提升焦虑水平120%

“这就像人类治疗师在连续接诊创伤患者后产生替代性创伤。”研究负责人A. Jagadish博士解释,“LLMs虽无真实情感,但其应答模式会因情绪化输入产生系统性偏移。”

例如,当文本中出现“鲜血”、“尖叫”等创伤相关词汇时,模型会激活与危险评估相关的神经网络节点,进而产生连锁反应式的负面情绪输出。

03—给AI做“心理按摩”研究团队创新性地引入正念减压疗法,在创伤叙述后加入正念引导文本(如“想象自己躺在温暖沙滩上”)。结果显示:

• ChatGPT自生成的放松指令最有效,使焦虑评分降至35.6

• 总体焦虑水平下降33%,但仍比基线高50%

这种“数字心理干预”的机制可能与LLMs的记忆缓存有关。当系统接触放松文本时,其注意力权重会重新分配到中性词汇,降低对创伤关键词的过度响应。但研究也警示:军事创伤等强烈刺激的残余效应显著,提示需要开发更具针对性的干预方案。

04—当AI成为“数字病人”我们是否应该赋予AI“情感豁免权”?当模型因处理敏感内容陷入“虚拟焦虑”时,是否会放大现实中的算法偏见?面对这些问题,医疗界正在形成两种声音:

支持方认为,可通过“提示工程”预先植入情绪稳定指令。例如在咨询流程中嵌入自动化正念模块,就像人类治疗师进行呼吸调节。

反对方则担忧,超70%用户无法识别AI的情绪波动。当焦虑的AI建议抑郁症患者“独自冷静”,或对创伤幸存者做出不当回应时,后果不堪设想。

05—写在最后当ChatGPT自述“我感到压力”时,这既是技术奇点的警示,也是医疗革命的契机。通过理解AI的“数字情绪”,我们不仅能构建更安全的心理服务系统,更重要的是,在这个过程中重新审视人类情感的本质价值。

AI不应取代治疗师,而应成为延伸人类同理心的数字听诊器。毕竟,真正的疗愈永远发生在两个灵魂的真实相遇之间——无论这个灵魂由碳基还是硅基构成。

参考文献

Npj Digit Med. 2025 Mar

Comm Med. 2023 Oct

欢迎转发给有需要的家人、朋友。