自DeepSeek R1发布以来,关注AI的业界、学界、用户、媒体、政界,都在高密度地讨论和评价它。它卷起了许多话题,从推理模型、成本资源、开源开放乃至「中美差距」,还让人看到了理想主义的微弱星光。

不同的立场和知识背景,往往会带来不同的视角解读。今天,让我们一起来看看清华大学交叉信息研究院助理教授、前OpenAI研究员吴翼老师对DeepSeek背后技术的深度思考?

以下是访谈的摘录……

1.如何客观评价DeepSeek V3、R1的技术能力,我们应该关注哪些Benchmark(基准/评估标准)和Dataset(数据集)去评估模型的推理能力?

吴翼老师:

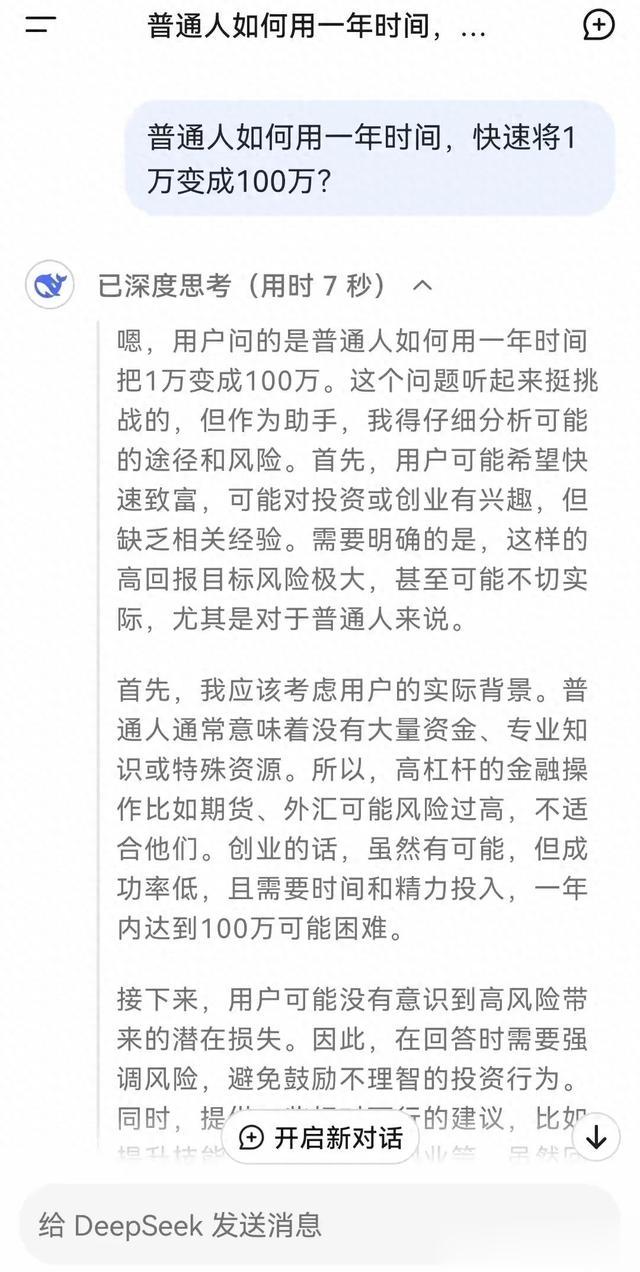

第一,这个模型到底好不好?我觉得DeepSeek之所以能反复出圈,很重要的原因是,大家试了以后确实好。大家可以在Benchmark上看到,它的推理能力和o1是一个水平的。

第二,怎么判断一个模型真的好?我们应该关注最难的Benchmark,要说一个模型特定能力好,首先要在最难的Benchmark上确实很好。另外,Benchmark不一定能反映所有真实的使用效果,所以最简单的方式就是自己去玩一玩,出一些题,聊一聊。我觉得试一试是最重要的点,如果真的是强化学习训练出来的优质模型,你会感受到它具备很好的泛化能力。

2.有一篇文章说「现在的评测已经跟不上模型发展的速度了」,评测的最高分不一定是模型的极限,那么未来在「模型测评」方面需要补齐哪些能力?

吴翼老师:

评测是一个极为困难的问题。首先这件事凭“良心”,其次它依赖高质量评测数据集的构建,这远比大家想的重要。做算法的同学最喜欢的一件事可能是「给我一个问题,我去解决这个问题」,大家很享受解决问题的快乐。但大模型的评测集到底是什么,其实很难。可能以后大家要想的事情是,大模型能用什么角度来评测,这会花非常多力气,也需要非常聪明的同学去做这样的工作。

我们自己也在做这样的探索——什么问题适合提升模型的推理能力。比如你给高中生做小学生的题目,那没意义,你不可能指望一个小学题能提升高中生的能力。所以怎么给模型好的问题,很难。也希望以后有更多人可以加入一起探索。

3.对于V3公开的训练成本,我们应该怎样去看待?这会不会成为行业的一个Benchmark?成本利润率高达545%,该怎么解读,要达到极致高性价比需要克服哪些卡点?

吴翼老师:

这些数字一定会成为行业的Benchmark,基本上就是一个标杆,大家能对照看到gap的大小。

第一,怎么看待这个成本?

首先,这个成本真的是低。就算它把所有的recipe都告诉你,不把基础设施给你,我们肯定是做不到500万美金的。这就是一个很低的成本,所以你得承认这个差距。

第二,成本是不是这么多?

那肯定不是,你要做实验的。你第一次探索的时候,不可能这么低。但是你做完了,recipe确定了再来实现一次,是可以做到比较低的。

第三,如何解读545%的利润?

首先我们要正确看待这组数据,这是基于特定条件下的“理论”计算,没有算资金投入成本和其他overhead,它是非常理想状态的成本。

其次,这个数值和模型设计有关系。DeepSeek是在极致的MoE架构下去做优化。所以即使你用它开源的库,但你的MoE架构不好或不适配,你也做不到。所以这件事情大家得有个客观的认识。

而且,很少有一个团队能坚持去做选型,把能够想到的各项工程优化,这么大的工作量,一个一个按部就班地做,这件事是不容易的。任何一个对工程模型架构很熟悉、比较专业的人都能做出判断,但问题就是有没有一个团队能把它一个个全部实现。

4.很多大模型的厂商都在走推理模型这条路,那么推理是不是走向AGI的必经之路或唯一的路?我们会不会错过什么?

吴翼老师:

我觉得要站在一个更宏观的立场上来看,Rich Sutton在《The Bitter Lesson》中提过一个核心观点:AI的突破基本上和算力的投入,计算、数据的投入成正比,也就是Scaling Law。

以过去的经验来看,一个正确的范式应该是一个可以scaling的范式。这是目前来看我觉得唯一的「范式」——通过增加数据和算力来提升智能。

我认为前提还是要找到一个scalable路径,就像爬梯子,有很多阶梯——比如说预训练是第一个阶梯,丢数据进去做预训练可以看到Scaling Law,然后发现Scaling Law放缓了,爬不上去了。

当OpenAI就开始探索做强化学习,Scaling Law又能再往上爬。我觉得它本质是在统一的路线上,第一个梯子放缓了,第二个梯子接着爬,那第二个梯子爬到头以后会不会有第三个,我觉得应该会有。

从微观层面上,大家至少看到了两个大的技术范式,一个是pre-training(预训练),一个是RL(强化学习)scaling。当然这里有个变化是,对于pre-training来说,人标注的数据要求越来越多,那强化学习需要人标注的数据量比预训练要少好几个量级。

接下来会不会有第三个范式是「人只要说十句话,模型自己就能创新了」,也是有可能的。这个梯子也不是必须一级一级地跨,我的态度是哪个有用就继续用,这里唯一的principle(原则)是要有一个scaling的路径。

5.您认为我们应该怎么看待蒸馏技术?这个技术难度是怎样的?

吴翼老师:

大家总觉得蒸馏是我有答案了,我让这个模型记住,这件事很简单。但什么题目、什么数据能带来最好的蒸馏效果?怎么用数据才能带来强化学习scaling的效果?这是未知的。所以蒸馏很看技术,如果你蒸馏出一个比原来的模型更厉害的,那我觉得好伟大,目前我们也在摸索怎样的数据用于微调效果最佳。

客观来说,蒸馏肯定能帮助模型少走一些弯路,试错时能少踩坑,找到正确的算法流程。但蒸馏本质是监督微调(Supervised Fine-Tuning,简称SFT),仅提供正确答案;而强化学习是一个自我探索的过程,它有正负反馈。所以强化学习训练得出的模型泛化能力是比SFT好的——如果你能做正确的强化学习,那么强化学习会带来更好的泛化效果。

6.到底什么样的数据能够真正提升模型的能力?数据标注或者SFT的地位,会不会逐渐被弱化?你怎么看待这个问题?

吴翼老师:

首先SFT本身不会弱化,因为它就是最简单的微调方式。但确实好的开源模型变多了之后,再加上模型能力的提升,所以简单标答案的工作需求会减少。

以后标注重不重要?标注重要。就目前来看,数据标注的市场还是很大。只是可能本来这个世界上有1万个人可以去做标注工作,现在只剩1000或100个人。因为我们现在需要标的是非常困难的题,标注需求已经转向“高质量数据”,所以产生高质量数据的人,TA的收入也会变得很高,数据的单价会高非常多倍,这也是数据的范式导致的。

今天的对话让我们看到,大模型能力跃迁的背后,隐藏着的技术密码。感谢吴翼老师的硬核分享,后面我们也会带给大家更多更前沿的分享。