首先要明白:商人就是商人,可不管你三七二十一的,能赚钱才是王道!

尤其是美帝的商人企业家们。

说来也是奇怪

说来也是奇怪前些天还被deepseek打得直不起腰的英伟达,竟又开始频频向deepseek示好了,甚至狂吹高捧。

据《日经亚洲》2月27日的报道,英伟达黄仁勋积极接受了采访,他指出,英伟达接下来要借助deepseek开始推动AI的发展。黄仁勋向DeepSeek靠拢的本质是将威胁转化为生态优势:通过整合算法创新,推动AI应用普及,进而扩大推理芯片市场。

换句话说,英伟达放弃了美国GPT这个不受世界人民所待见的“算力堆积起来的AI智障”。

“几乎每个开发商”都在学习中国公司的 R1 模式,这将推动芯片销售。对黄老板来说,什么东西能带那他赚钱他就吹什么。

更讽刺的是,黄仁勋的“拍马屁”本质上是求生欲的体现。

更讽刺的是,黄仁勋的“拍马屁”本质上是求生欲的体现。他在回应中反复强调“推理需求将暴增100倍”,试图将DeepSeek的算法突破包装成硬件需求的催化剂。然而市场早已看穿:当中国企业能用1%的成本实现同等效果,谁还需要堆砌天价GPU?

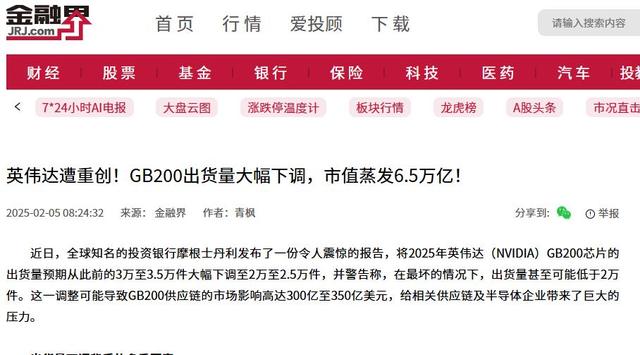

仅用550万美元和2048块H800 GPU训练出对标GPT-5的推理能力,而OpenAI同类模型动辄需要数亿美元和数万块GPU。这种“降维打击”直接导致英伟达单日市值蒸发6000亿美元,黄仁勋个人财富缩水超130亿美元。

这种痛苦,老黄不想再经历第二次了!

美国AI泡沫的底层逻辑,建立在两个假设之上:

美国AI泡沫的底层逻辑,建立在两个假设之上:1. 算力决定一切:没有数万块H100和千亿参数,就不可能训练出顶级模型;

2. 开源等于低端:闭源模型才能形成技术壁垒,开源只是小玩家的玩具。

而DeepSeek用三记重拳粉碎了这种傲慢:成本颠覆:R1模型训练成本仅为硅谷巨头的1/100,参数效率提升5倍;

开源生态:连续开源Flash MLA、DeepEP等核心代码库,吸引全球开发者构建“非英伟达生态”;

-技术反超:在多模态模型Janus-Pro的测试中,70亿参数版本直接碾压DALL-E3。

这不仅仅是技术突破,更是商业逻辑的降维打击。当中国企业证明“算法优化可以替代算力堆砌”,美国科技巨头过去三年烧掉的数千亿美元AI投资,瞬间变成了“无效内卷”的泡沫。

如今黄仁勋开始狂吹deepseek,也不过是在捷足先登地给大众灌输一个思想:

如今黄仁勋开始狂吹deepseek,也不过是在捷足先登地给大众灌输一个思想:黄仁勋指出,投资者错误地将AI发展简化为“预训练→推理”两个割裂阶段,认为DeepSeek-R1的开源意味着“算力需求见顶”,但实际推理阶段的算力消耗远超训练。

说白了,他觉得要发展AI,终究还是离不开他的英伟达。

这句话对,但也没有那么对,科技告诉发展的今天,没有谁是不可替代的,尤其是芯片的原材料还被我们卡着的时候。

所以很明显,美国AI产业正经历“斯普特尼克时刻”

所以很明显,美国AI产业正经历“斯普特尼克时刻”——正如1957年苏联发射首颗人造卫星迫使美国追赶航天技术,DeepSeek的崛起迫使硅谷重新思考AI的本质:是继续沉迷于算力霸权,还是拥抱开源与效率革命?

当黄仁勋们不得不向DeepSeek“低头”,全球AI产业的权杖,正在悄然易主。

(本文部分数据及观点引自英伟达财报、黄仁勋公开访谈、DeepSeek技术白皮书以及第三方研报,事实性内容均有据可查。)

---