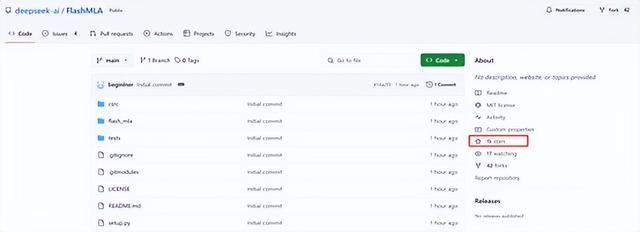

今早9点30,国内著名开源大模型平台DeepSeek开启了本周连续5天技术分享的第1天,开源了针对HopperGPU优化的高效MLA解码内核——FlashMLA。

刚在Github发布瞬间就破了1000颗星,DeepSeek现在就是国内外大模型开源界的顶流。

开源地址:https://github.com/deepseek-ai/FlashMLA

网友表示,第一天就这么劲爆的嘛,真是太棒了,恭喜你们完成了如此令人印象深刻的工作和细节。

DeepSeek的FlashMLA快得简直像是在Hopper GPU上表演单口相声——3000 GB/s 和 580 TFLOPS,哇,接下来是什么,是和你的烤面包机进行实时对话,还是在早餐前实现完全的AGI?

太棒的 CUDA 内核了!请继续保持出色的工作!

「AIGC开放社区」为大家简单解读一下FlashMLA吧,这是一种专门针对Hopper GPU优化的内核,用于加速多头注意力解码过程。

在自然语言处理任务中,输入序列的长度往往是不定的,而FlashMLA针对这种情况进行了专门的优化。这种优化可以减少不必要的计算资源浪费,从而提高整体效率。

此外,FlashMLA还支持BF16,这是一种降低了精度但不会显著影响结果的浮点数格式。支持BF16不仅可以加速计算过程,还能节省存储空间和带宽,对于大规模深度学习任务来说尤为重要。

FlashMLA还采用了分页KV缓存技术,通过将键值对缓存分页化(块大小为64),能够更智能地利用内存,并加快检索速度,进而提高上下文管理的效率。这种缓存机制在处理大规模数据时尤其有效,能够显著提升系统的整体性能。

在H800 GPU上,FlashMLA展现了卓越的性能指标。它达到了3000 GB/s的内存带宽,内核能够高效地进行内存传输,从而减少内存瓶颈对性能的影响。

同时,FlashMLA还实现了580 TFLOPS的计算性能,在处理高数据吞吐量和计算密集型任务时表现非常出色。

本文素材来源DeepSeek,如有侵权请联系删除