2025 年的今天,AI 眼镜越发成为焦点,或许我们可以大胆地猜测,未来的 AI 助手不是藏在手机 App 里,而是戴在你脸上、看你所看、答你所问。

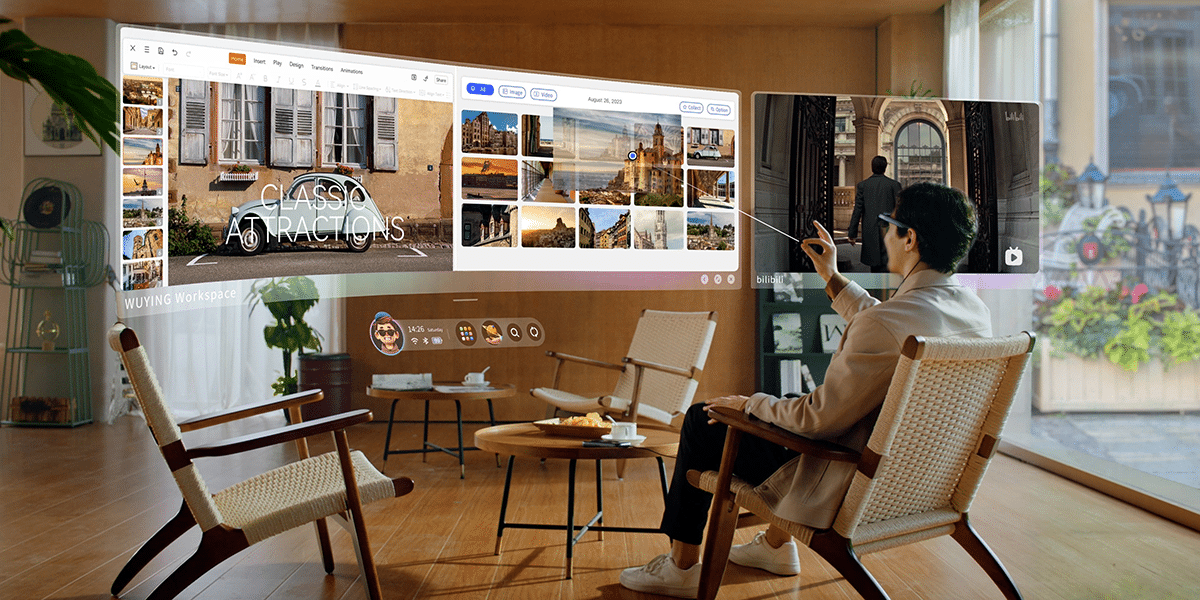

4 月举办的 TED 大会上,Google 也给出了自己的答案。在 TED 官方上周最新发出的视频中,谷歌首次公开展示了搭载 Android XR 的 AI 眼镜,如何在 Gemini AI 的加持下如何运行:

不仅能听懂语言、即时翻译,还能「看见」世界,甚至记住用户曾看过的物体、识别书名、直接播放唱片上的音乐、叠加导航指引。

图/ TED

这场现场演示,也再次引发了外界对于 AI 眼镜的广泛热议。诚然,这不是 Google 第一次做眼镜,也不是第一款 AI 眼镜,但它背后是 Google 最新构建的 XR 系统平台 Android XR,也是 Gemini 大模型首次与现实空间深度融合的结果。

尤其在 Meta、Rokid、雷鸟等厂商接连发布 AI 眼镜后,Google Android XR 的这次「下场」,也被视作 AI 眼镜「平台战争」的新号角。但 Android XR 能够复制 Android 在智能手机市场的成功吗?或许很难。

Google 做的 AI 眼镜,到底有什么不一样?在 TED 放出演讲视频《The next computer? Your glasses》中,能够很明显看到 Google 打造的 AI 眼镜,很像一副普通眼镜。别误会,这是大势所向。

进行演示的 Google AI 眼镜,图/ TED

不同于 AR 眼镜过去的张扬设计,今天 AI 眼镜追求的就是越像普通眼镜越好,以便于消费者在日常生活中无感地进行使用。包括 Google 这副看似朴素的智能眼镜,一开始或许不如 Vision Pro 那样炫技,但当 AI 开始真正「看懂」世界,它释放出的潜力,足够让人重新想象 AI 眼镜的未来。

其中最引发热议的,就是 Gemini 展示出的「记忆」能力。

我们可能都见过这样的演示:戴着 AI 眼镜对着某个画面询问 AI。不过 TED 现场的演示中,Google 不只是展示了这类实时响应,让 Gemini 看着现场写俳句(日本的一种古典短诗)。

但更让人惊喜的是,Google 员工 Nishtha Bhatia 只是轻轻瞥了一眼身后的书架,然后背身再等了一段时间,才询问眼镜「后面架子上那本白色封皮的书叫什么?」,随后 Gemini 秒答:

那是詹姆斯·克利尔所著的《Atomic Habits》(中文版译名为《掌控习惯》)。

Gemini 有记忆的能力,图/ TED

不仅如此,Gemini 还能提前记住看过的信息,然后在之后的询问中直接告诉 Nishtha Bhatia 房卡放在了唱片旁边。相比之前 AI 眼镜只能「问答」或「识图」,Google 这次展示的 AI 眼镜,在「连续性」和「上下文感知」方面,可以说迈进了新的维度。

这不是传统意义上的图像识别,而是近乎具备了「视觉记忆」的 AI。用户视线已经离开,AI 却「记住了」曾经看到的物体。换句话说,它也不只是识别「是什么」,而是真正能理解「你在问什么」。不过 Google 也留下了一些疑问:

AI 眼镜上 Gemini 的「记忆窗口」能有多长?

但无论如何,这都是我们之前在所有 AI 眼镜中,没能看到的。当然,这主要还是得益于 Gemini 模型的能力,理论上随着其他第三方大模型的迭代和释放,其他 AI 眼镜也能实现。

AI眼镜=AI+AR,这也是Google的看法TED 现场的这场演讲之所以引发广泛关注,不仅因为 Gemini 的「记忆力」突破,更因为 Google 这次交出的,是一副具备 AR 显示能力的 AI 眼镜。

关注 Google Project Astra 项目的朋友可能还会记得,2022 年谷歌官宣收购了一家名为 Raxium 的 MicroLED 显示屏公司,当时就引发了诸多猜想。而在 TED 演讲中,Google XR 负责人 Shahram Izadi 就透露,现场演示的 AI 眼镜搭载了 MicroLED 显示屏。

Shahram Izadi 展示 AI 眼镜显示屏,图/ TED

从视频中的演示也可以看出,Gemini 的交互界面直接出现在镜片中,不只是在耳边回应,还会透过光波导镜片展现在眼前。这种形态 AI 眼镜的优势,我们已经说过很多回:

核心在于纯语音交互天然存在体验上的障碍,而视觉+听觉的交互体验,更符合人类天生的认知和交互习惯。

还是拿 Google 的现场演示来说,Gemini 能够在回复——不管是回答还是翻译直接呈现在眼前让人阅读,不仅作为观众的他者,就连进行演示的 Nishtha Bhatia 本人也能非常高效地了解信息,而不用等待 Gemini 的逐词念出。更不用说,嘈杂环境下,就连更靠近耳道的开放式耳机也很难,遑论 AI 眼镜。

除此之外,显示能力的加入也带来了更多的交互可能,比如最直接的就是——AR 导航。通过将数字信息透过眼镜叠在眼前,Google AI 眼镜能够进行在现实空间中进行为用户进行更直观的导航,包括实际的方向、距离和路线。

这种轻量化 AR 能力的加持,当然也不只是 Google 一家在做。

Rokid Glasses,图/ Rokid

事实上,雷科技多次在 AI 眼镜报道中提到的 Rokid Glasses 就率先采用了这种 AI+AR 的路线,配备了双目 AR 显示,支持信息推送、空间导航、翻译字幕、AI 对话等功能。另一边,Meta 与雷朋(Ray-Ban)合作的下一代智能眼镜,也被英国《金融时报》爆料将在今年晚些时候加入 AR 显示功能。

但想要做好 AI+AR 显示,并不简单,其实背后蕴含的是对空间感知、视觉识别和语义推理的整合能力,同时也代表了 AI 眼镜从「语音驱动」跨越到「多模态交互」的重要节点。

Google 欲再造Android奇迹,但很难Google 这次带来的 AI 眼镜背后,是一个新名字——Android XR。虽然披着 Android 的外衣,但它其实是 Google 为 XR(扩展现实)设备打造的一套全新操作系统架构,主打融合语音交互、视觉感知和空间定位等能力。

换句话说,它不是给手机用的 Android,而是 Google 想在下一代计算平台上,再复制一次 Android 的生态奇迹。

但现实是,今天的 AI 眼镜,不是 15 年前的智能手机。

回看 AI 眼镜行业的现状,我们几乎看到每一家头部厂商都在自研操作系统。Rokid 自研了空间操作系统 YodaOS-Master,这是专为空间计算与多模态 AI 交互设计的操作系统。Meta 也有自己的 Horizon OS,不仅强调空间操作系统定位,甚至计划向第三方开放。

YodaOS-Master,图/ Rokid

简单来说,大家早已不再指望 Android 给 XR 提供答案。Google 推出 Android XR 时,虽然能打出「兼容 Android 应用」的优势牌,但这张牌,现实里其实越来越轻了。

智能手机之所以需要操作系统标准,是因为它承载的是高频 App 使用场景:社交、支付、娱乐、地图……都需要一个稳定的生态容器。

但 AI 眼镜不是手机,它的核心交互逻辑并不依赖「打开某个 App」,而是基于语音、图像和上下文理解的即时响应。在 TED 的演示中,我们也可以看到,用户不需要点击任何图标,不需要跳转任何应用——只要说出来、看过去、问一句,就能触发系统执行:

- 看到书架,问书名;

- 看向唱片,播放歌曲;

- 嘴里说「去哪」,导航就展开。

这些体验很多都不太依赖庞大的 App 生态,而更接近服务即操作、意图即执行的系统级协作。硬要说的,Gemini 或者说 AI 才是真正的关键。在这方面,Gemini 很强,但还远不能「力压群雄」。

写在最后从 TED 演示的那副眼镜出发,我们看到 Google 正试图用 Gemini 重构 AI 眼镜的交互方式,并借由 Android XR 再次发起一场平台级的进攻。它做出了真正「看得见」的 AI 眼镜,也带来了记忆、导航、翻译等一整套超越传统的体验。

但要构建一个真正意义上的平台,靠炫目的演示还远远不够。Android XR 面临的不只是技术挑战,还有群雄的市场格局,以及用户交互迁移的巨大挑战。包括当用户不再「打开 App」,而是与 AI 直接对话时,什么才是平台?

这也是 Google 此前所有 XR 项目始终未能落地的症结所在——它太擅长构建系统,却始终没找到下一个系统存在的理由。

但无论如何,AI 眼镜确实展现了成为新一代个人计算平台的巨大潜力,至于 Android XR 能不能成为那个定义标准的平台,还是需要我们抱有耐心,见证历史。