教程目录

1、Ollama方式本地电脑部署(CMD窗口使用)

2、本地部署(Cherry Studio客户端)

3、硅基流动API部署deepseek R1满血版(Cherry Studio客户端)

4、腾讯云部署deepseek R1满血版(网页版+Cherry Studio客户端)

5、科大讯飞部署deepseek R1满血版(网页版+Cherry Studio客户端)

一、本地部署(Ollama方式)Ollama是一个用于管理和部署机器学习模型的工具,让用户能够轻松地在本地运行、管理和与大型语言模型进行交互1.下载 Ollamahttps://ollama.com/Ollama

目前 Ollama 支持 macOS、Linux、Windows,选择相应的系统下载即可,我的是windowns11系统,下面演示基于win系统。

添加图片注释,不超过 140 字(可选)

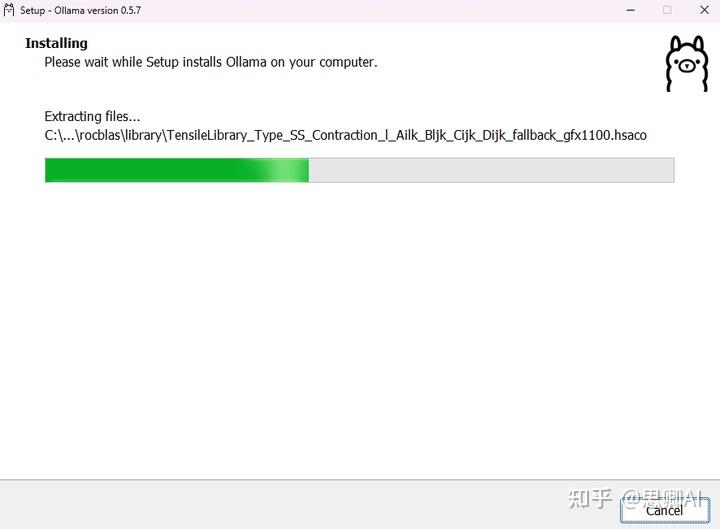

2.安装Ollama下载完成后安装Ollama,默认安装在C盘,建议不要改安装目录,不然得重新配置环境变量参数,deepseek r1模型默认下载也会在C盘,下面会教大家改模型存储位置。

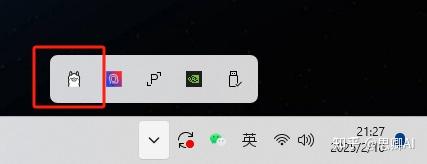

安装完成后任务栏会显示Ollama图标。

添加图片注释,不超过 140 字(可选)

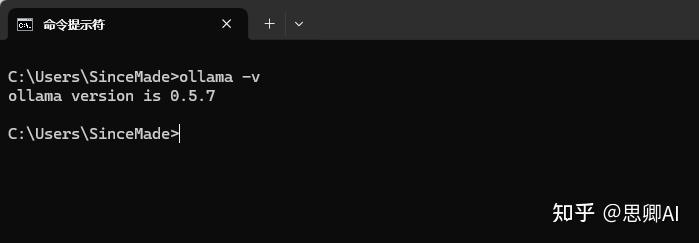

打开cmd命令窗口,输入ollama -v查看是否安装成功及版本。

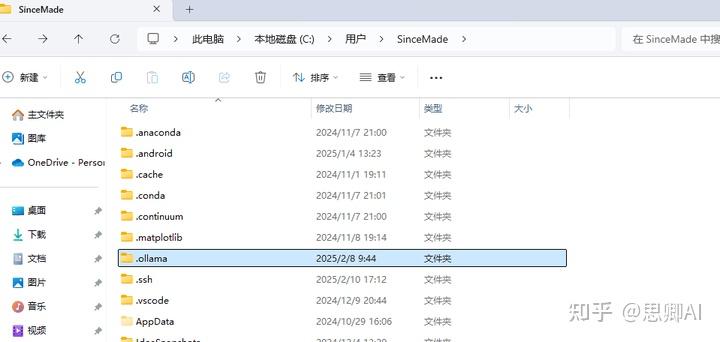

模型的下载位置默认在C:\Users\SinceMade.ollama,我们将.ollama这个文件夹剪切到其他盘,例如我放在F盘,并修改文件夹为ollama。

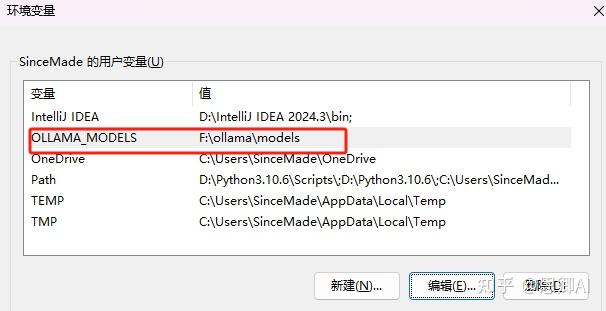

新建用户环境变量名OLLAMA_MODELS,值为刚刚ollama的文件夹。

重启ollama工具后【右键任务栏ollama图标,点击Quit Ollama】,模型的安装路径更改完成。

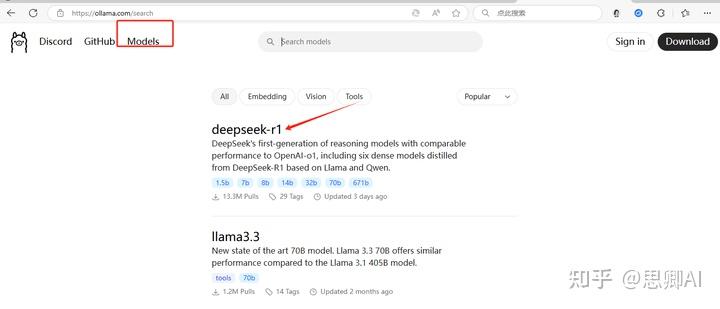

3.下载deepseek r1大模型进入Ollamahttps://ollama.com/Ollama官网,点击Moudels,第一个就是deepseek R1大模型

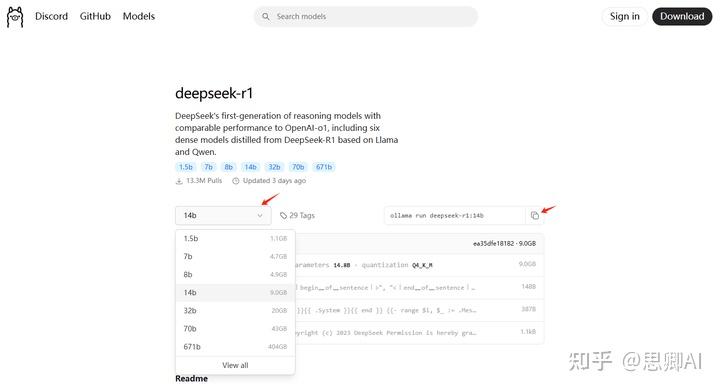

点击模型进入详细页面,选择要下载的模型版本后,点击复制按钮复制下载命令

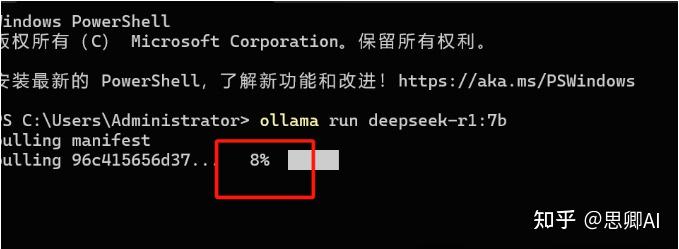

打开CMD命令窗口,将下载命令复制进来,看到进度条后即开始下载,剩下的耐心等待即可。

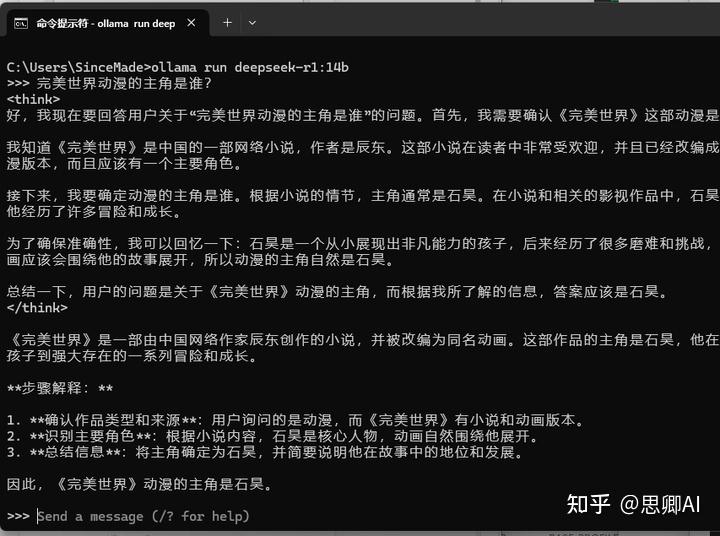

模型下载完成后出现>>>表示安装完成,可以在窗口直接输入要对话的内容开始对话?

要退出命令行窗口,按Ctrl+D,要重新运行命令行窗口的对话模型,复制下载模型版本的命令即可,例如ollama run deepseek-r1:14b。

结论本地部署依赖电脑配置,配置越好,对话体验越好

安全隐私性最高,完全免费

二. LLM 客户端使用deepseek r1虽然终端可以使用了,但是还是不太方便。所以就有很多界面交互工具 LLM 客户端出现,例如chatbox、Cherry Studio、OpenWebUI 等等,博主推荐【Cherry Studio】,拥有多项预配置 AI 助手且可自定义创建,支持多种文件格式并具备 WebDAV 文件管理功能,还有全局搜索、主题管理等实用工具,与 ollama 结合可更好地实现本地模型的个性化应用和管理,并且可以搭建本地知识库。下载Cherry Studio。

https://cherry-ai.com/

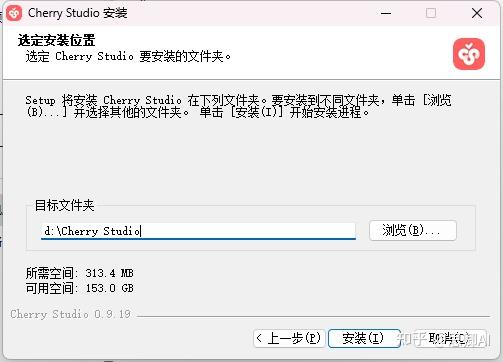

安装及配置Cherry Studio,不建议放在C盘。

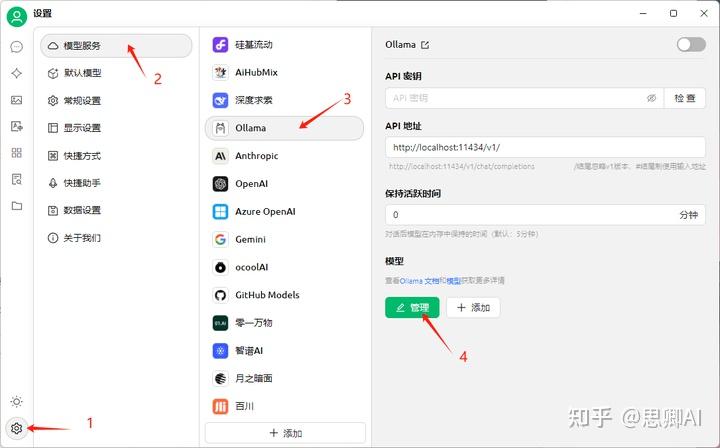

配置Cherry Studio 【1】打开Cherry Studio,点击设置按钮; 【2】点击模型服务; 【3】选择Ollama; 【4】点击管理模型;

【5】选择下载的deepseek r1模型,我下载的是14B版本;

【6】点击检查,提示连接成功即可使用。

使用Cherry Studio 【1】设置默认模型为deepseek r1

【2】添加默认助手即可开始对话

Cherry Studio客户端操作方便

支持管理本地模型及API模型

支持搭建本地知识库

强烈推荐

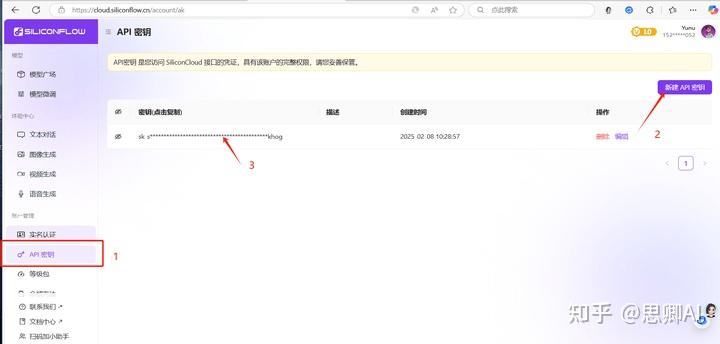

三、硅基流动部署Deepseek R1满血版1.注册账号https://cloud.siliconflow.cn/i/luCh4xfw

【1】点击API密钥 【2】点击创建 【3】点击密钥进行复制

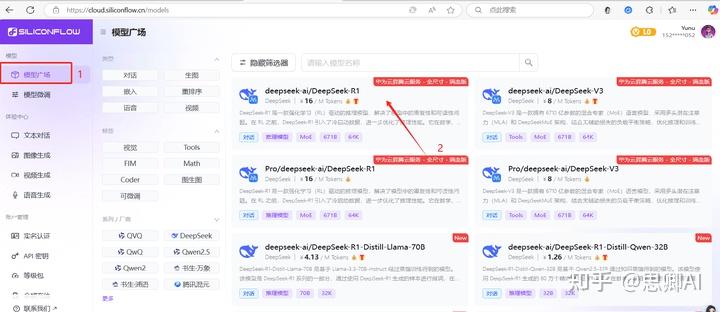

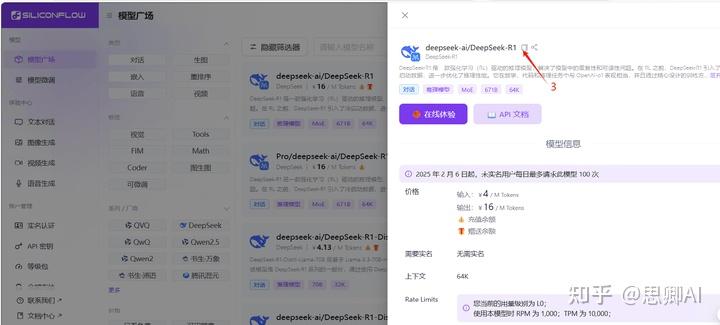

【1】选择模型广场 【2】点击deepseek-ai/DeepSeek-R1满血版 【3】点击复制

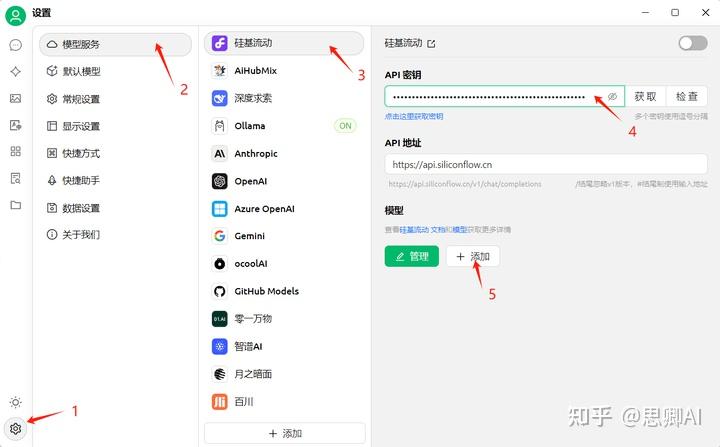

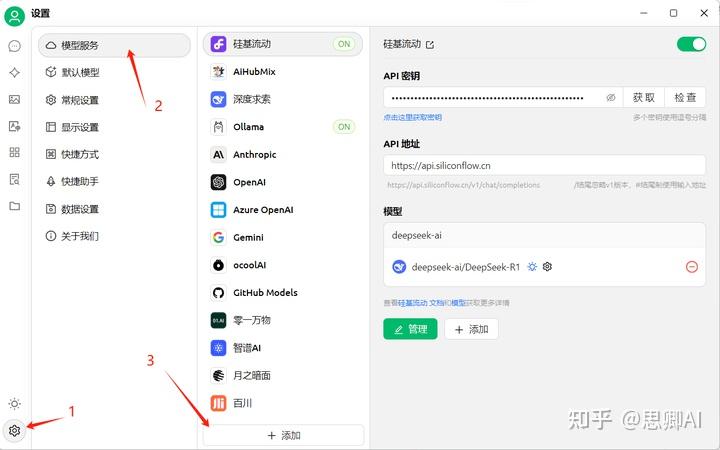

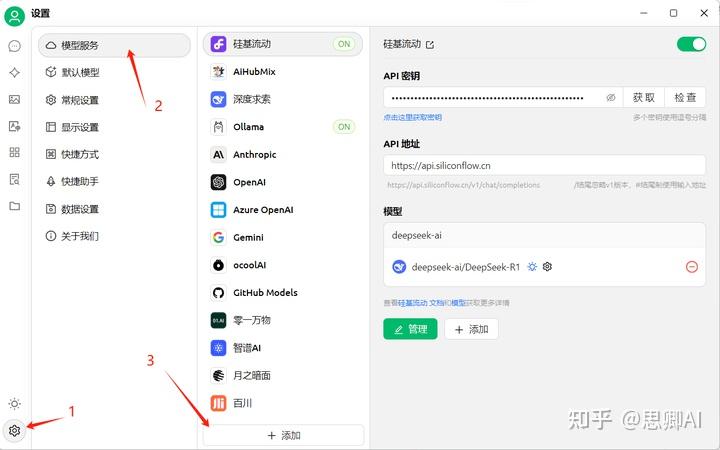

配置Cherry Studio硅基流动 【1】点击设置按钮 【2】选择模型服务 【3】选择硅基流动 【4】粘贴刚刚复制的API密钥 【5】添加DeepSeek R1模型

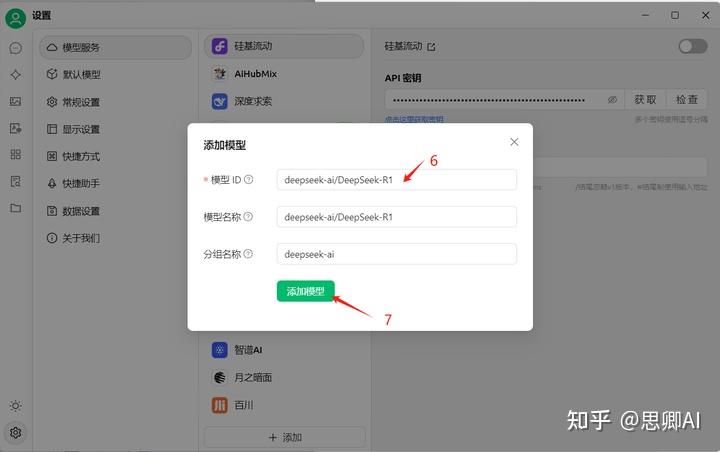

【6】粘贴刚刚复制的deepseek-ai/DeepSeek-R1满血版模型 【7】添加模型

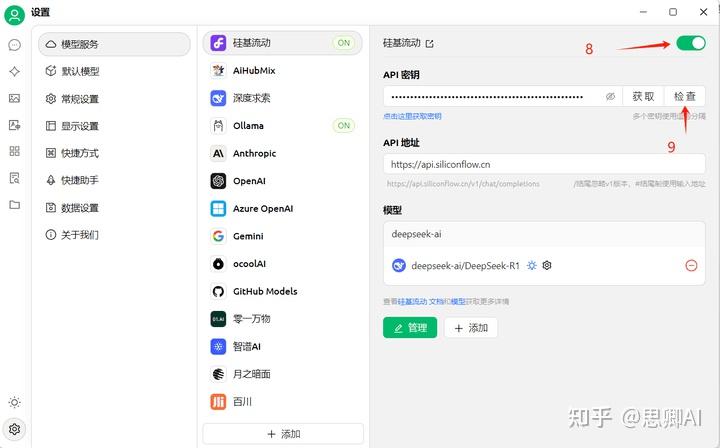

【8】打开硅基流动开关 【9】点击检查测试API的连接情况,出现连接成功即可使用

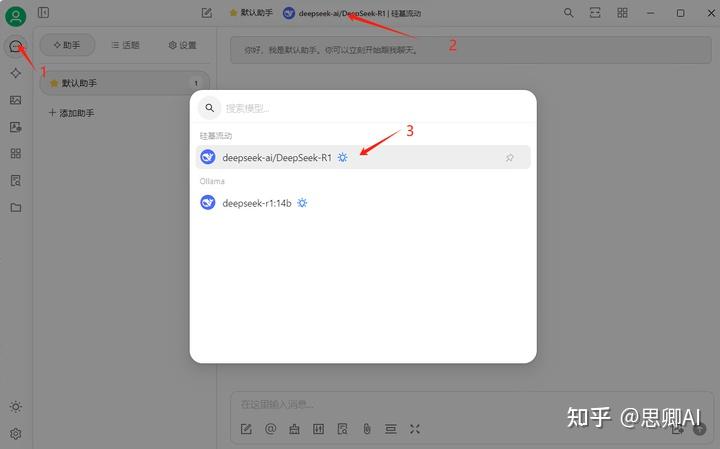

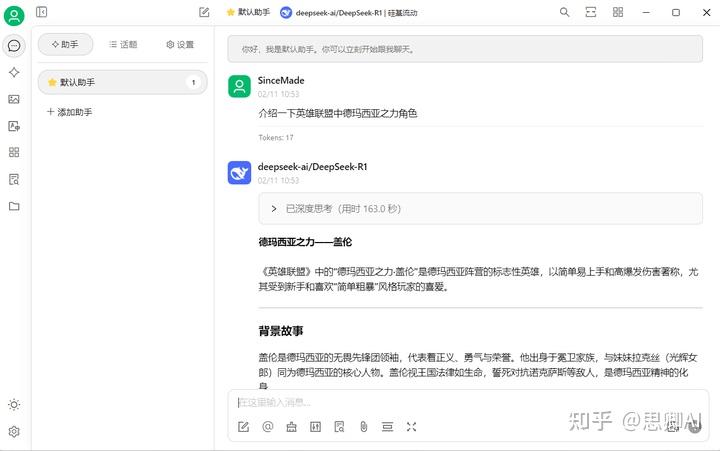

使用硅基流动API进行Deepseek R1满血版对话 【1】点击对话窗口 【2】切换助手模型 【3】选择硅基流动的DeepSeek R1

【4】输入对话内容,即可使用DeepSeek R1满血大模型

硅基流动API方式目前同样很火,导致响应很慢

新用户注册有一定的API调用额度,使用完毕后会收取一定费用

四、腾讯云部署DeepSeek R1满血版截止2025年2月25日,所有腾讯云用户均可享受DeepSeek-V3,DeepSeek-R1模型限时免费服务,在此之后,模型价格将回复至原价。1.注册/登录腾讯云https://curl.qcloud.com/vjvX9NH1 【新用户请按界面指引完成实名认证】

https://lke.cloud.tencent.com/lke#/experience-center/home?origin=all

点击立即体验

可以使用腾讯的网页版Deepseek

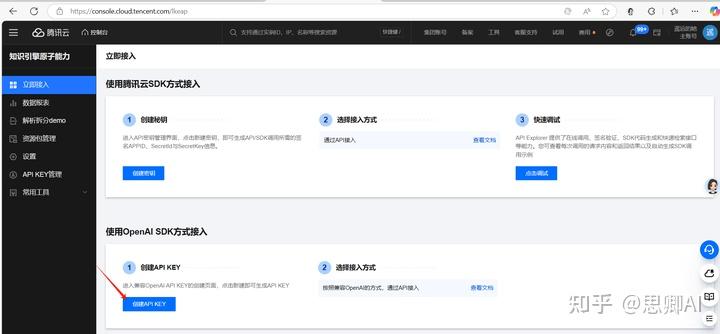

https://console.cloud.tencent.com/lkeap

选择使用OpenAI SDK方式接入

点击创建API KEY

点击查看并复制API KEY

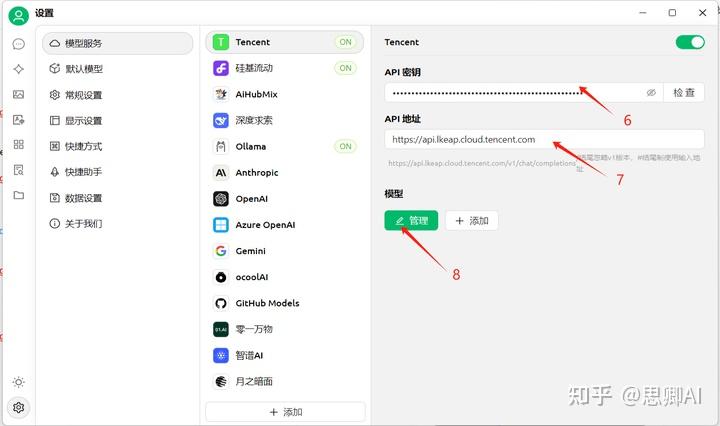

配置步骤 【1】点击设置 【2】点击模型服务 【3】点击添加模型服务

【4】供应商名称可随意填写,此处我填写Tencent 【5】点击确定

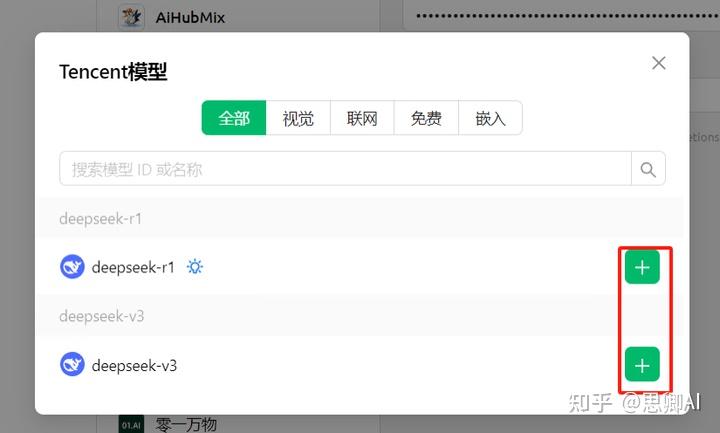

【6】API密钥粘贴腾讯用中复制的API KEY 【7】API地址:https://api.lkeap.cloud.tencent.com 【8】点击管理模型

【9】模型ID:点击添加DeepSeek R1和DeepSeek V3模型

【10】检查连接情况,提示连接成功即可使用

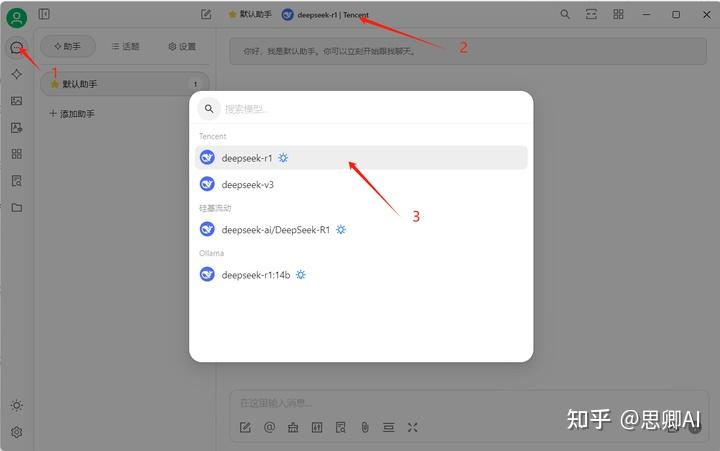

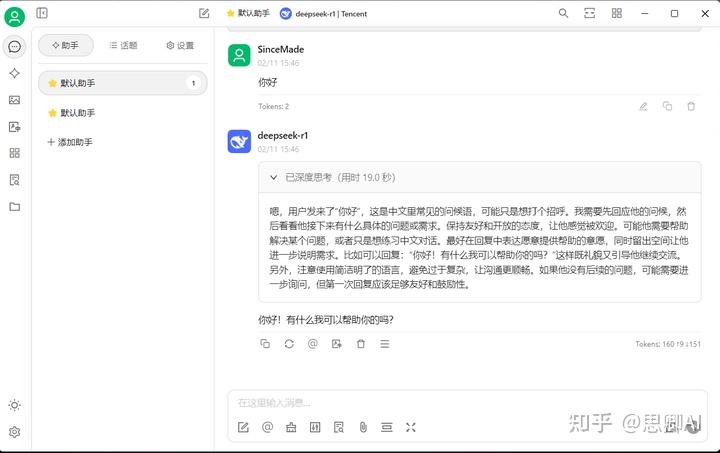

使用步骤 【1】点击对话窗口 【2】切换助手模型 【3】选择腾讯云的DeepSeek R1

【4】输入对话内容,即可使用DeepSeek R1满血大模型

速度快,能体验到满血大模型

2025年02月25日前免费使用,到期后会收取一定费用,具体费用看腾讯云怎么规定

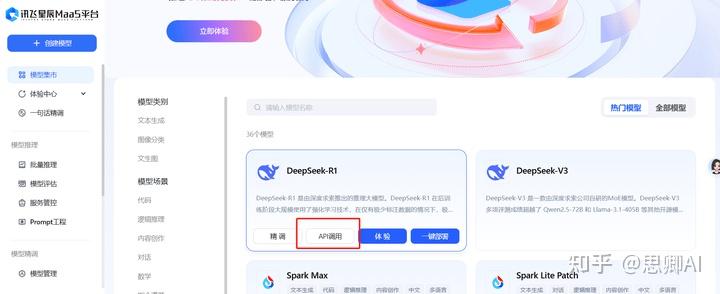

五、科大讯飞部署Deepseek R1满血版限时免费:即日起至3月10日,DeepSeek 推理API免费开放 ⚡独享部署:专属模型“一键部署”,按实例运行时长付费,“即用即销” 全栈支持:从模型训练、部署调试到场景优化,提供99.97% SLA云服务1.注册讯飞开放平台https://passport.xfyun.cn/login

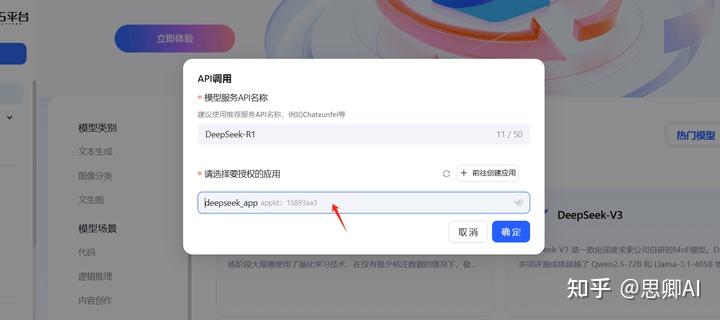

【1】点击API 调用

【2】模型名称填写DeepSeek-R1,点击创建应用

【3】点击新建应用

【4】应用名称随意填写,例如deepseek_app,应用分类可以参考我这个选择,应用功能描述也可以随便填写

【5】点击提交后,在应用列表会出现刚刚创建的应用

【6】返回模型调用页面,选择要授权的应用为刚刚创建的应用

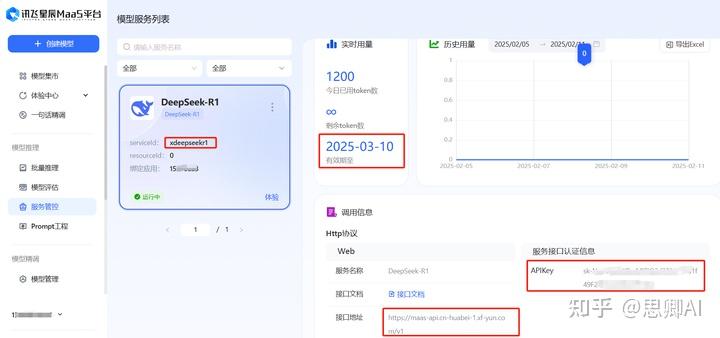

【7】此时可以看到模型服务情况,包括:serviceId:xdeepseekr1,token有效期,APIKey,接口地址等关键信息

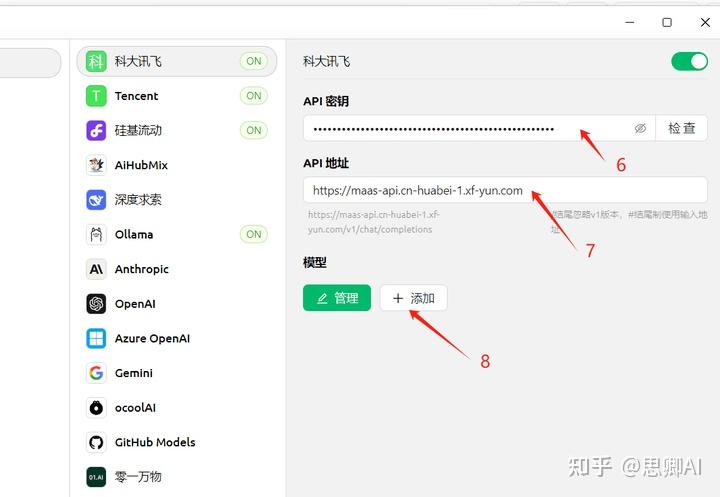

配置步骤 【1】点击设置 【2】点击模型服务 【3】点击添加模型服务

【4】供应商名称可随意填写,此处我填写科大讯飞 【5】点击确定

【6】API密钥填写模型服务情况中的API Key 【7】API地址:https://maas-api.cn-huabei-1.xf-yun.com,注意后面没有/v1

【8】点击添加模型

【9】模型ID:填写讯飞模型服务中的serviceId值,即xdeepseekr1

【10】检查连接情况,提示连接成功即可使用

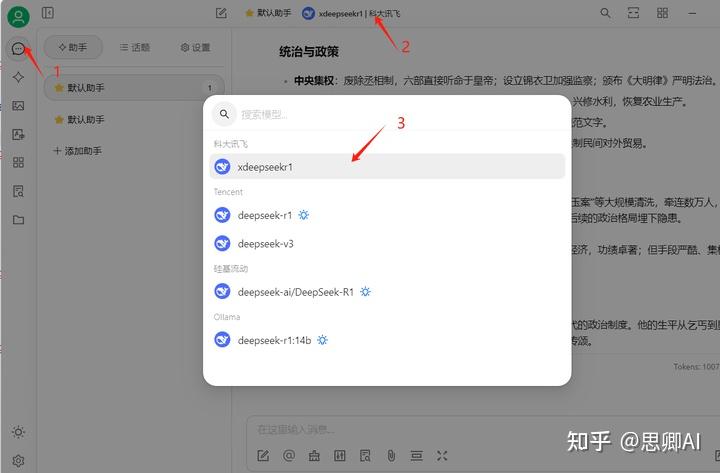

使用步骤 【1】点击对话窗口 【2】切换助手模型 【3】选择科大讯飞的DeepSeek R1

【4】输入对话内容,即可使用DeepSeek R1满血大模型

速度快,能体验到满血大模型

2025年3月10日前免费使用,到期后会收取一定费用

写在最后推荐使用腾讯云和科大讯飞API模式,如果deepseek官网可以正常访问的话,直接使用官网原生的最好

欢迎关注我,后续我继续为大家带来更多的AI工具教程分享

大有想了解的或者对本文章不清楚的评论区随时留言