20分钟在Windows操作系统部署DeepSeek-R1大模型

| 原创作者/编辑:凯哥Java | 分类:人工智能学习系列教程

GitHub上deepseek-r1截图

PS:本文是本地化部署DeepSeek系列教程第三篇。本系列共计5篇文章,最终,我们讲实操在Windows操作系统和Mac操作系统实现本地部署DeepSeek-R1大模型。

本系列教程其他文章,还在文章末尾添加。欢迎系统学习

点击下方“凯哥Java”

一起用AI进化、赚钱...

让成长不再孤独!

本文使用到以下几个软件:Ollama、DeepSeek、和 ollama-webui-lite-main

DeepSeekDeepSeek 是一个强大的开源AI模型系列,由深度求索(DeepSeek)开发,专为多领域应用设计。它提供了多个版本的模型:

• DeepSeek-Coder:专注于代码开发的AI助手,擅长理解和生成多种编程语言的代码

• DeepSeek-Chat:通用对话模型,支持中英双语,能够处理从日常对话到专业领域的广泛问题

• DeepSeek-MoE:基于专家混合的大规模语言模型,能够根据需求调动多个专家模型进行高效计算特点:开源、性能强大,特别在代码理解、生成和多领域应用中表现优异,适合开发者和研究人员使用。

OllamaOllama 是一个轻量级的本地AI模型运行框架,旨在简化开源大语言模型的部署和使用:

• 支持多种主流AI模型,如 Llama、Mistral 等,可轻松进行本地部署

• 部署过程简单,通过一行命令即可启动,无需复杂配置

• 完全本地运行,确保用户数据隐私和安全

• 提供灵活的自定义模型和参数调整选项,适合开发者进行个性化实验特点:轻量、简便,适合个人开发者或小型团队在本地运行AI模型,注重简化使用流程。

ollama-webui-lite-mainollama-webui-lite-main 是基于 Ollama 框架的 Web 用户界面,旨在提供更简便的本地AI模型交互体验:

• 简洁直观的Web界面,用户可通过浏览器与本地运行的AI模型进行交互

• 无需复杂配置,快速部署,适合个人或小型团队使用

• 支持多种开源AI模型,便于模型切换与调试

• 提供简单的参数调整界面,帮助用户根据需求优化模型表现特点:基于 Ollama 框架的Web界面,简化了AI模型的本地操作体验,适合开发者或小型团队进行高效管理与实验。

三款软件的总结:

• DeepSeek:高质量开源AI模型,专注于多领域和代码开发,适合需要强大模型支持的用户

• Ollama:轻量本地AI部署框架,适合简化本地模型部署和数据隐私保护的用户

• ollama-webui-lite-main:Web界面化工具,简化了Ollama框架的操作,适合需要快速与本地模型交互的开发者

根据需求,用户可以:

• 需要高性能开源模型时选择 DeepSeek

• 想要快速部署并保护数据隐私时选择 Ollama

• 需要简单便捷的Web界面与本地AI模型交互时选择 ollama-webui-lite-main

一、初识 Ollama

介绍:

Ollama 是一个轻量级的本地AI模型运行框架,旨在简化开源大语言模型的部署和使用。它支持多种主流的开源大语言模型(如 Llama、Mistral 等),并提供简洁、易用的命令行工具,使开发者能够在本地计算机上方便地部署和运行这些模型。Ollama 强调数据隐私,确保所有计算过程都在本地进行,避免了将敏感数据发送到云端的风险。

优势:

1. 简便易用:Ollama 通过简单的一行命令即可启动和部署AI模型,大大降低了模型部署的复杂度,适合开发者和个人用户使用。

2. 本地部署,数据安全:所有数据和计算都发生在本地,不会上传至云端,极大保证了用户的数据隐私和安全。

3. 支持多种模型:支持如 Llama、Mistral 等多种开源大语言模型,可以根据需求自由选择和替换模型。

4. 灵活的自定义:Ollama 提供了灵活的自定义选项,开发者可以根据自己的需求调整模型和参数,以达到最佳的性能。

5. 资源占用低:作为轻量级框架,Ollama 对计算资源的需求相对较低,适合在普通硬件上运行,减少了云计算的依赖。

使用场景:

1. 个人开发和实验:对于个人开发者来说,Ollama 提供了一个便捷的方式来本地部署和测试各种大语言模型,适合进行快速原型设计和小型项目开发。

2. 小型团队和研究机构:小型开发团队或研究人员可以利用 Ollama 在本地部署 AI 模型,无需依赖外部服务,这样不仅能节省成本,还能避免数据外泄的风险。

3. 数据隐私保护:对于有严格数据隐私需求的用户,如医疗、金融等行业,Ollama 提供本地运行的解决方案,确保敏感数据不会泄露。

4. 本地大语言模型服务:在不依赖云端的情况下,Ollama 可以帮助用户搭建本地的大语言模型服务,适用于需要快速响应的场景,如本地聊天机器人、智能客服等。

5. 自定义 AI 模型调试与优化:Ollama 的自定义选项使得开发者可以根据需要调整和优化模型,对于AI开发者而言,测试不同配置并找到最佳设置是非常有价值的。

二、下载

访问官网:https://ollama.com/

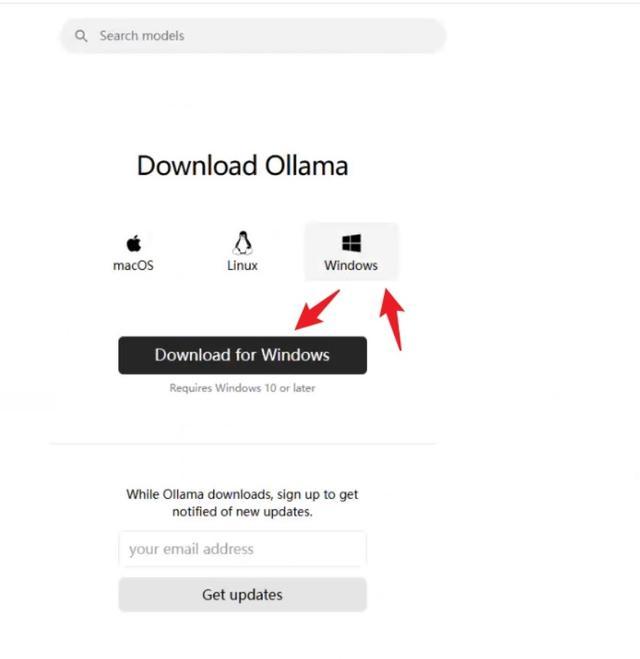

在官网首页可以直接看到下载按钮,点击下载按钮,根据自己的电脑操作系统选择对应的安装包。

因为凯哥电脑是Windows操作系统的,所以,直接点击Windows图标后下载即可。如上图所示。

需要注意:因为Ollama是国外的,所以下载可能会有点慢,凯哥将下载好的文件已经放网盘了,有需要的朋友可以直接回复后获取。

(链接:https://pan.quark.cn/s/d3d39615b800 提取码:MRL3)

三、安装

3.1 配置环境变量

从凯哥提供网盘下载安装包之后,我们可以看到是EXE文件。一般来说,我们会直接双击,然后进行安装,在这里,先别着急这双击安装。先设置下环境变量。

可能有些朋友会问,为什么配置环境变量呢?因为Ollama以及我们需要下载的模型都是默认安装在C盘的,一般情况下,我们会给C盘分配的磁盘不是很大。所以,如果使用的久或者是我们下载多个模型之后,C盘会爆满。所以,需要把下载的模型存放在非系统盘中就可以。具体配置如下:

搜索环境变量,找到环境变量:

双击编辑系统环境。如下图:

输入如下内容:

变量名称

变量值

说明

OLLAMA_MODELS

G:\ollama\models

变量值根据自己实际情况修改。别放在C盘就可以

具体操作步骤如下图:

3.2 安装Ollama

配置好环境变量之后,就可以双击Ollama即可,然后一直点击下一步就可以看装成功了

3.3 验证是否安装成功

等待安装完成之后,打开CMD命令窗口

(如果不知道怎么打开,直接按键盘上的win+R,在弹窗框输入cmd)

输入ollama 或者 ollama -v 。如果看到如下图,说明安装成功了。

3.4 配置软链接

为什么要配置软链接呢?

原因同3.1。在3.1步骤咱们只是配置了模型存放路径。ollama主程序和日志文件还在C盘。这一步就是为了将这些还在C盘的配置到其他盘符。

看到了吗?Ollama占用了4.56GB的磁盘空间呢。所以,咱们很有必要把主程序和日志文件存放到其他盘符去。

需要注意:

1.在配置软链接之前请先退出已经在运行的ollama。怎么退出?桌面右下角,可以看到ollama图标,然后鼠标右键就可以看到退出按钮了。点击退出即可

2.cmd必须使用管理员权限运行。具体操作如下:

PS:如果第一步忘了。那么在执行创建软链接命令前,需要多执行一步。就是将原来的路径奔赴。之后才能配置软链接。创建完成之后,记得把备份文件夹中的内容拷贝回去,再次验证是否可以用。

安装后在C盘\用户文件夹下可以看到如下几个目录

路径

说明

C:\Users\kaizi\.ollama

存放模型的

C:\Users\kaizi\AppData\Local\Ollama

存放Ollama日志相关

C:\Users\kaizi\AppDatalLocal\Programs\Ollama

存放Ollama主程序的

说明:请将kaizi换成你自己电脑的用户名

Windows操作系统创建软链接命令:

Plain Textmklink /D 需要创建软连的原始目录 创建软连的目标目录

根据上面公式可以得到:

比如凯哥要创建存放模型的软链接到D盘ollama文件夹下。执行命令如下:

Plain Textmklink /D C:\Users\kaizi\.ollama D:\ollama\.ollama

三个软链接执行命令如下:

mklink /D C:\Users\kaizi\.ollama D:\ollama\.ollama

mklink /D C:\Users\kaizi\AppData\Local\Ollama D:\ollama\logs

mklink /D C:\Users\kaizi\AppDatalLocal\Programs\Ollama D:\ollama\app

说明:

1.把kaizi换成你自己的

2.把软链接目标文件夹修改成你自己的

错误问题解决

1.提示已经存在了:

把之前的备份下。备份命令:

Plain Textmove C:\Users\kaizi\.ollama C:\Users\kaizi\.ollama_backup

先执行move之后,在执行创建软链接命令就可以了。如下图所示:

2.在移动文件夹的时候,如果提示拒绝访问

如果提示拒绝访问,说明文件夹正在被使用中,没有把右下角ollama关闭。

四、下载模型

在官网,点击左上角的Models,可以看到deepseek-r1。如下图:

点击deepseek-r1就可以看到模型了

①:选择需要的模型大小

②:模型模型安装命令

五、安装模型

这里,凯哥就使用大多数电脑可以运行的模型:ollama run deepseek-r1 。大家复制即可。

复制命令后,直接在cmd命令窗口下执行即可。

因为大小是4.7GB,下载需要会时间。耐心等着。下载完成后,见到如上图所属,说明已经下载完了

六、命令窗口下测试模型

等模型安装完成之后,咱们就可以直接和模型进行对话了。

比如,直接输入,你是谁,然后就可以看到如下回答

在命令行测试,可以发现效果还可以,速度不慢。推理能力确实很强!朋友们,赶紧试试吧

七、安装WebUI前环境准备

PS:如果不想使用凯哥提供的这个,也可以使用ChatBox这类的。chatBox怎么使用,凯哥在之前文章中也讲解过了。

虽然直接在命令行中运行模型很方便,但为了获得更好的用户体验,您可以将Qwen2模型集成到Web界面中。

1. 安装Node.js:

首先,需要在Windows上安装Node.js。访问Node.js官网,下载并安装最新版本的Node.js。

凯哥使用的是版本号是18.6

image.png

凯哥本地node版本

2. 下载ollama-webui:

从GitHub或其他源下载ollama-webui的代码。

JSONhttps://github.com/ollama-webui/ollama-webui-lite

3. 设置并启动Web界面:

按照ollama-webui的文档说明,设置Node.js环境,安装依赖,并启动Web服务器。然后,在浏览器中打开Web页面,选择您的模型即可开始对话。

3.1镜像提速:

入ollama-webui文件夹,设置国内镜像源提速:

JSONnpm config set registry http://mirrors.cloud.tencent.com/npm/

3.2 安装依赖

JSONnpm install

错误解决办法:

如果报错说要audit,则依次进行即可:

JSONnpm auditnpm audit fix

启动

3.3 启动Web界面:

命令执行完成就可以用看到如下图的访问地址:

image.png

启动成功输出访问地址

打开Web页面,选择你的模型即可开始对话:

image.png

访问页面

八、启动webUI界面并测试模型

凯哥这里选择8b模型进行测试。

通过页面访问,也是响应也是挺快的。