什么是决策树?使用决策树有什么好处?

决策树(Decision Tree)是一种基于树状结构的机器学习算法,用于解决分类和回归问题。

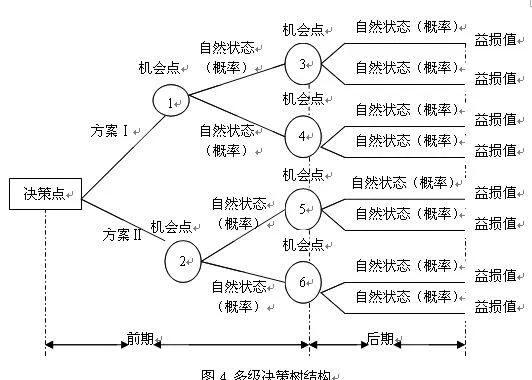

其核心思想是通过对数据特征的逐层判断(类似于“如果-那么”规则),最终到达叶子节点(决策结果)。

• 结构:由根节点(起始特征)、内部节点(特征判断)和叶子节点(分类/回归结果)组成。

• 构建方法:通过信息增益(ID3)、基尼不纯度(CART)、信息增益率(C4.5)等指标选择最优分割特征,递归生成分支。

决策树的优点

1. 直观易懂• 树状结构可视化后,决策逻辑清晰,非技术人员也能理解(例如:“如果年龄>30 且收入高,则批准贷款”)。

2. 无需复杂数据预处理• 对数据标准化、缺失值不敏感,可直接处理数值型和类别型特征。

3. 自动特征选择• 通过信息增益等指标自动筛选重要特征,减少无关特征的干扰。

4. 高效处理非线性关系• 不需要假设数据线性可分,能捕捉特征间的复杂交互作用。

5. 计算成本低

5. 计算成本低• 训练和预测速度快,适合中小规模数据集。

6. 支持分类和回归任务• 分类树(如 CART)和回归树(预测连续值)均可实现。

7. 可扩展性强• 可作为集成模型(如随机森林、梯度提升树)的基础组件。

典型应用场景

典型应用场景• 分类问题:客户流失预测、疾病诊断、垃圾邮件识别。

• 回归问题:房价预测、销量预估。

• 特征重要性分析:识别影响结果的关键因素(如用户购买决策的主因)。

注意事项• 过拟合风险:树可能过于复杂(例如深度过大),需通过剪枝(Pruning)或设置最大深度控制。

• 不稳定性:数据微小变化可能导致树结构显著不同,可通过集成方法缓解。

总结来说,决策树以高可解释性和灵活性著称,是机器学习的入门算法,尤其适合需要透明决策逻辑的场景(如金融风控、医疗诊断)。