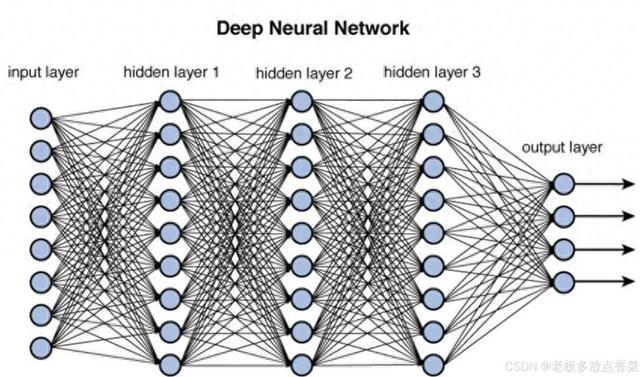

神经网络模型作为人工智能和深度学习领域的核心技术,近年来取得了突破性进展,推动了计算机视觉、自然语言处理、语音识别等领域的革新。以下介绍十大经典神经网络模型,涵盖其核心结构、创新点及应用场景。

1. LeNet-5:卷积神经网络的奠基之作核心结构:由Yann LeCun于1998年提出,是首个成功应用于手写数字识别的卷积神经网络(CNN)。其结构包括输入层、两个卷积层(C1、C3)、两个池化层(S2、S4)、两个全连接层(F5、F6)及输出层。创新点:通过卷积层提取局部特征,池化层降低特征维度,全连接层实现分类,奠定了CNN的基本框架。应用场景:手写数字识别(如MNIST数据集)、早期OCR系统。

2. AlexNet:深度学习的开山之作

2. AlexNet:深度学习的开山之作核心结构:2012年ImageNet竞赛冠军模型,由Alex Krizhevsky提出,包含8层网络(5个卷积层、3个全连接层),首次使用ReLU激活函数和Dropout正则化。创新点:引入GPU加速训练,显著提升计算效率;通过局部响应归一化(LRN)增强泛化能力。应用场景:图像分类、目标检测(如RCNN系列模型)。

3. VGGNet:深度与简洁的结合核心结构:牛津大学视觉几何组(Visual Geometry Group)提出,采用堆叠3×3小卷积核,构建16层(VGG-16)和19层(VGG-19)网络。创新点:通过小卷积核堆叠替代大卷积核,减少参数量的同时提升非线性表达能力;网络结构简洁,易于扩展和优化。应用场景:图像分类、特征提取(作为预训练模型)。

4. GoogLeNet(Inception系列):高效计算与参数共享核心结构:2014年ImageNet冠军模型,提出Inception模块,通过并行使用1×1、3×3、5×5卷积核及3×3池化层,实现多尺度特征提取。创新点:引入辅助分类器(Auxiliary Classifiers)缓解梯度消失问题;通过深度可分离卷积降低计算复杂度。应用场景:图像分类、移动端视觉任务(如MobileNet系列)。

5. ResNet:残差学习的革命核心结构:2015年ImageNet冠军模型,提出残差块(Residual Block),通过跳跃连接(Skip Connection)实现恒等映射,解决深层网络退化问题。创新点:允许网络深度突破1000层,显著提升模型性能;残差学习机制成为后续深度网络的标准设计。应用场景:图像分类、目标检测(如FPN)、语义分割(如DeepLab)。

6. DenseNet:密集连接的网络核心结构:受ResNet启发,提出密集块(Dense Block),通过将每一层与之前所有层直接连接,实现特征重用。创新点:减少参数数量,缓解梯度消失问题;增强特征传播和梯度流动。应用场景:图像分类、图像生成(如与GAN结合)。

7. LSTM(长短时记忆网络):序列建模的里程碑核心结构:针对传统RNN的梯度消失问题,提出门控机制(输入门、遗忘门、输出门),实现长期依赖建模。创新点:通过门控单元控制信息流动,有效捕捉长序列依赖关系。应用场景:语音识别、机器翻译、时间序列预测。

8. GRU(门控循环单元):LSTM的简化版本核心结构:在LSTM基础上简化门控机制,仅保留更新门和重置门,减少参数数量。创新点:计算效率更高,性能接近LSTM;广泛应用于资源受限场景。应用场景:语音合成、自然语言处理。

9. GAN(生成对抗网络):无监督学习的巅峰核心结构:由生成器(Generator)和判别器(Discriminator)组成,通过对抗训练生成逼真数据。创新点:开创无监督学习新范式,实现图像生成、风格迁移等任务。应用场景:图像生成(如StyleGAN)、数据增强、图像修复。

10. Transformer:自然语言处理的新范式核心结构:基于自注意力机制(Self-Attention),完全抛弃循环结构,实现并行计算。创新点:显著提升长序列处理能力,成为NLP领域的主流模型。应用场景:机器翻译(如BERT、GPT)、文本生成、多模态学习。

总结这十大经典神经网络模型代表了深度学习领域的重要突破,从卷积神经网络到生成对抗网络,再到Transformer,它们推动了计算机视觉、自然语言处理等领域的快速发展。未来,随着硬件技术的进步和算法的不断创新,神经网络模型将在更多领域展现其潜力,为人工智能的发展注入新的动力。